Der vielleicht wichtigste Teil des Umfrageprozesses ist die Erstellung von Fragen, mit denen die Meinungen, Erfahrungen und Verhaltensweisen der Öffentlichkeit genau gemessen werden. Genaue Stichproben werden verschwendet, wenn die gesammelten Informationen auf einem wackeligen Fundament mehrdeutiger oder voreingenommener Fragen beruhen. Um gute Maßnahmen zu erstellen, müssen sowohl gute Fragen geschrieben als auch zum Fragebogen organisiert werden.

Fragebogen-Design ist ein mehrstufiger Prozess, der die Aufmerksamkeit auf viele Details auf einmal erfordert. Das Entwerfen des Fragebogens ist kompliziert, da Umfragen unterschiedlich detailliert nach Themen fragen können, Fragen auf unterschiedliche Weise gestellt werden können und Fragen, die früher in einer Umfrage gestellt wurden, beeinflussen können, wie Personen auf spätere Fragen antworten. Forscher sind auch häufig daran interessiert, Veränderungen im Laufe der Zeit zu messen, und müssen daher darauf achten, wie Meinungen oder Verhaltensweisen in früheren Umfragen gemessen wurden.

Vermesser können Pilotversuche oder Fokusgruppen in den frühen Stadien der Fragebogenentwicklung durchführen, um besser zu verstehen, wie Menschen über ein Problem denken oder eine Frage verstehen. Das Pretesting einer Umfrage ist ein wesentlicher Schritt im Fragebogen-Designprozess, um zu bewerten, wie Personen auf den Gesamtfragebogen und spezifische Fragen antworten, insbesondere wenn Fragen zum ersten Mal gestellt werden.

Seit vielen Jahren näherten sich Vermesser dem Fragebogendesign als Kunst, aber umfangreiche Forschungen in den letzten vierzig Jahren haben gezeigt, dass es eine Menge Wissenschaft gibt, die mit der Erstellung eines guten Fragebogens verbunden ist. Hier, Wir diskutieren die Fallstricke und Best Practices beim Entwerfen von Fragebögen.

Fragenentwicklung

Die Entwicklung eines Fragebogens umfasst mehrere Schritte. Die erste besteht darin, zu ermitteln, welche Themen in der Umfrage behandelt werden. Für Umfragen des Pew Research Center geht es darum, darüber nachzudenken, was in unserem Land und in der Welt passiert und was für die Öffentlichkeit, die politischen Entscheidungsträger und die Medien relevant sein wird. Wir verfolgen auch die Meinung zu einer Vielzahl von Themen im Laufe der Zeit, so dass wir oft sicherstellen, dass wir diese Trends regelmäßig aktualisieren, um besser zu verstehen, ob sich die Meinungen der Menschen ändern.

Im Pew Research Center ist die Fragebogenentwicklung ein kollaborativer und iterativer Prozess, bei dem sich Mitarbeiter treffen, um Entwürfe des Fragebogens im Laufe seiner Entwicklung mehrmals zu diskutieren. Wir testen häufig neue Umfragefragen im Voraus durch qualitative Forschungsmethoden wie Fokusgruppen, kognitive Interviews, Pretesting (oft mit einer Online-Opt-In-Stichprobe) oder eine Kombination dieser Ansätze. Die Forscher nutzen die Erkenntnisse aus diesen Tests, um Fragen zu verfeinern, bevor sie in einer Produktionsumfrage, z. B. im Internet, gestellt werden.

Messung von Veränderungen im Laufe der Zeit

Viele Vermessungsingenieure möchten Veränderungen in den Einstellungen, Meinungen und Verhaltensweisen der Menschen im Laufe der Zeit verfolgen. Um Veränderungen zu messen, werden Fragen zu zwei oder mehr Zeitpunkten gestellt. Ein Querschnittsdesign befragt verschiedene Personen in derselben Population zu mehreren Zeitpunkten. Ein Panel wie das ATP befragt im Laufe der Zeit dieselben Personen. Es ist jedoch üblich, dass sich die Anzahl der Personen in Umfragepanels im Laufe der Zeit ändert, wenn neue Panelisten hinzugefügt werden und einige frühere Panelisten ausfallen. Viele der Fragen in Umfragen des Pew Research Center wurden in früheren Umfragen gestellt. Wenn wir dieselben Fragen zu verschiedenen Zeitpunkten stellen, können wir über Änderungen in den Gesamtansichten der Öffentlichkeit (oder einer Teilmenge der Öffentlichkeit, z. B. registrierte Wähler, Männer oder schwarze Amerikaner) oder über das, was wir als „Trending“ bezeichnen, berichten die Daten“.

Bei der Messung von Veränderungen im Zeitverlauf ist es wichtig, den gleichen Fragenwortlaut zu verwenden und sensibel darauf zu achten, wo die Frage im Fragebogen gestellt wird, um einen ähnlichen Kontext wie bei der vorherigen Frage beizubehalten (siehe Fragenwortlaut und Fragenreihenfolge für weitere Informationen). Alle unsere Umfrageberichte enthalten einen Fragebogen in der obersten Zeile, der den genauen Wortlaut und die Reihenfolge der Fragen sowie die Ergebnisse der aktuellen Umfrage und früherer Umfragen enthält, in denen wir die Frage gestellt haben.

Der Übergang des Zentrums von der Durchführung von US-Umfragen durch Live-Telefoninterviews zu einem Online-Panel (etwa 2014 bis 2020) erschwerte einige Meinungstrends, andere jedoch nicht. Meinungstrends, die nach sensiblen Themen fragen (z. B. persönliche Finanzen oder Gottesdienstbesuch) oder die freiwillige Antworten hervorriefen (z., „weder noch“ oder „weiß nicht“) über das Telefon tendenziell größere Unterschiede als andere Trends zeigen, wenn von Telefonumfragen auf die Online-Umfrage verlagert. Das Zentrum verfolgte mehrere Strategien zur Bewältigung von Änderungen der Datentrends, die mit dieser Änderung der Methodik zusammenhängen können. Wenn es Hinweise darauf gibt, dass eine Trendänderung auf den Wechsel von Telefon- zu Online-Messungen zurückzuführen ist, kennzeichnen Center-Berichte diese Möglichkeit für die Leser, Verwirrung oder falsche Schlussfolgerungen zu vermeiden.

Offene und geschlossene Fragen

Eine der wichtigsten Entscheidungen, die beeinflussen können, wie Menschen Fragen beantworten, ist, ob die Frage als offene Frage gestellt wird, bei der die Befragten eine Antwort in ihren eigenen Worten geben, oder als geschlossene Frage, bei der sie aufgefordert werden, aus einer Liste von Antwortmöglichkeiten auszuwählen.

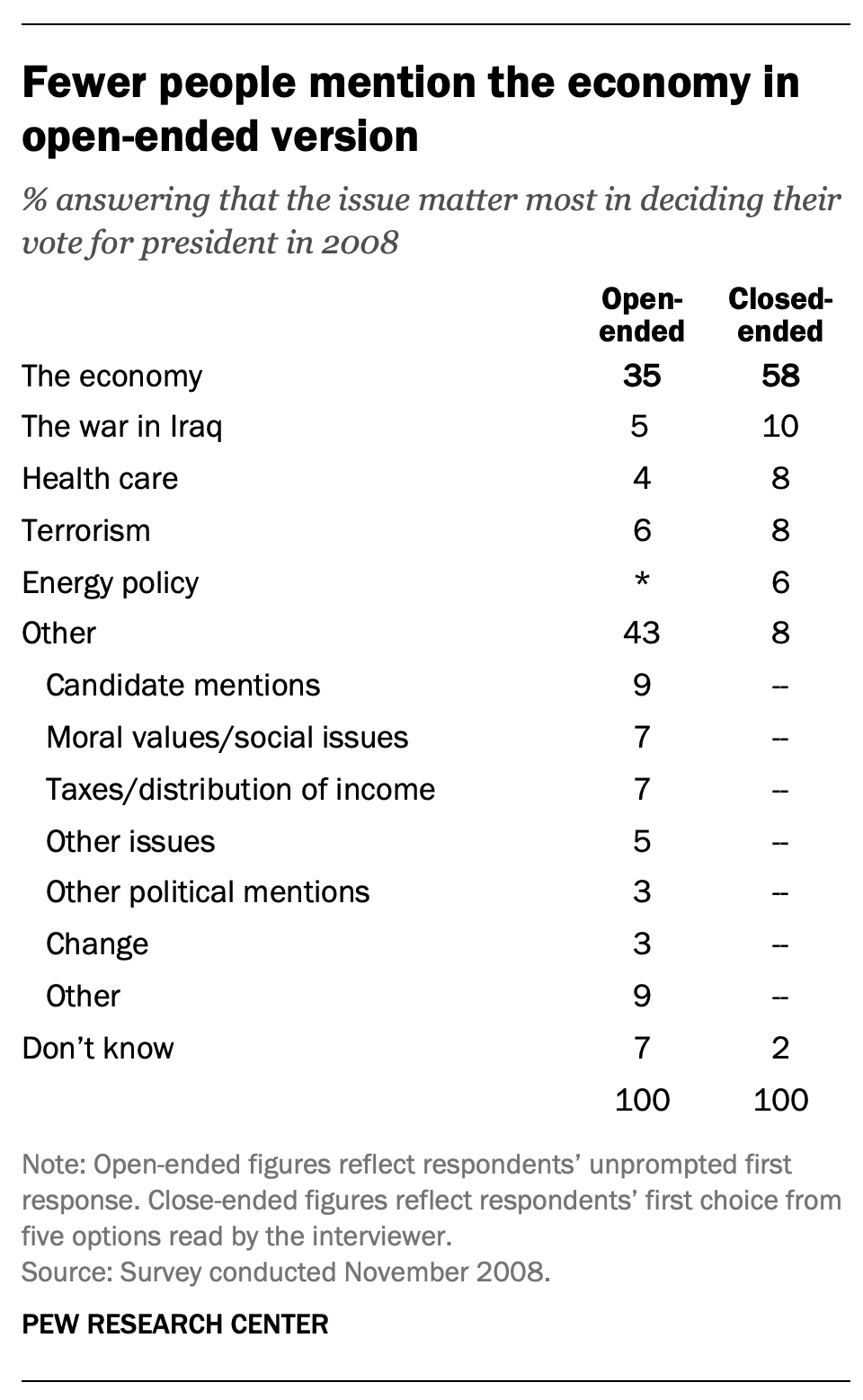

In einer Umfrage, die nach den Präsidentschaftswahlen 2008 durchgeführt wurde, reagierten die Menschen beispielsweise sehr unterschiedlich auf zwei Versionen der Frage: „Welches Thema war Ihnen bei der Entscheidung, wie Sie für den Präsidenten gestimmt haben, am wichtigsten?“ Einer war geschlossen und der andere offen. In der geschlossenen Version erhielten die Befragten fünf Optionen und konnten eine Option freiwillig angeben, die nicht auf der Liste stand.

Wenn explizit die Wirtschaft als Antwort angeboten wurde, wählte mehr als die Hälfte der Befragten (58%) diese Antwort; Nur 35% derjenigen, die auf die offene Version geantwortet haben, gaben freiwillig die Wirtschaft an. Darüber hinaus gab unter den Befragten, die nach der geschlossenen Version gefragt wurden, weniger als jeder Zehnte (8%) eine andere Antwort als die fünf, die sie gelesen hatten. Im Gegensatz dazu gaben 43% derjenigen, die nach der offenen Version gefragt wurden, eine Antwort, die nicht in der geschlossenen Version der Frage aufgeführt war. Alle anderen Ausgaben wurden zumindest etwas häufiger gewählt, wenn sie explizit in der geschlossenen Version angeboten wurden, als in der offenen Version. (Siehe auch „Gute Noten für die Kampagne, eine hohe Messlatte für Obama“ für weitere Informationen.)

Forscher führen manchmal eine Pilotstudie mit offenen Fragen durch, um herauszufinden, welche Antworten am häufigsten sind. Sie werden dann entwickeln geschlossene Fragen basierend auf dieser Pilotstudie, die die häufigsten Antworten als Antwortoptionen enthalten. Auf diese Weise können die Fragen besser widerspiegeln, was die Öffentlichkeit denkt, wie sie ein bestimmtes Problem sehen oder bestimmte Probleme ans Licht bringen, die den Forschern möglicherweise nicht bekannt waren.

Wenn Sie geschlossene Fragen stellen, können die Auswahl der bereitgestellten Optionen, die Beschreibung der einzelnen Optionen, die Anzahl der angebotenen Antwortoptionen und die Reihenfolge, in der die Optionen gelesen werden, die Reaktion der Personen beeinflussen. Ein Beispiel für die Auswirkungen der Definition von Kategorien ist eine Umfrage des Pew Research Center vom Januar 2002. Als die Hälfte der Stichprobe gefragt wurde, ob es für Präsident Bush „wichtiger sei, sich auf die Innenpolitik oder die Außenpolitik zu konzentrieren“, wählten 52% die Innenpolitik, während nur 34% die Außenpolitik sagten. Als die Kategorie „Außenpolitik“ auf einen bestimmten Aspekt – den „Krieg gegen den Terrorismus“ – eingegrenzt wurde, entschieden sich weit mehr Menschen dafür; Nur 33% wählten die Innenpolitik, während 52% den Krieg gegen den Terrorismus wählten.

In den meisten Fällen sollte die Anzahl der Antwortmöglichkeiten auf eine relativ kleine Anzahl beschränkt werden – nur vier oder vielleicht höchstens fünf –, insbesondere bei telefonischen Umfragen. Psychologische Forschung zeigt, dass es Menschen schwer fällt, mehr als diese Anzahl von Entscheidungen gleichzeitig zu berücksichtigen. Wenn es sich bei der Frage um eine objektive Tatsache und / oder demografische Merkmale handelt, z. B. die Religionszugehörigkeit des Befragten, können weitere Kategorien verwendet werden. In der Tat werden sie ermutigt, Inklusivität zu gewährleisten. Zum Beispiel umfassen die Standard-Religionsfragen des Pew Research Center mehr als 12 verschiedene Kategorien, beginnend mit den häufigsten Zugehörigkeiten (protestantisch und katholisch). Die meisten Befragten haben keine Probleme mit dieser Frage, weil sie erwarten können, ihre religiöse Gruppe in dieser Liste in einer selbstverwalteten Umfrage zu sehen.

Zusätzlich zur Anzahl und Auswahl der angebotenen Antwortoptionen kann die Reihenfolge der Antwortkategorien beeinflussen, wie Personen auf geschlossene Fragen antworten. Untersuchungen legen nahe, dass die Befragten in Telefonumfragen häufiger Elemente auswählen, die später in einer Liste zu hören sind (ein „Aktualitätseffekt“), und in selbstverwalteten Umfragen dazu neigen, Elemente ganz oben auf der Liste auszuwählen (ein „Primat“ -Effekt).

Aufgrund von Bedenken hinsichtlich der Auswirkungen der Kategorienreihenfolge auf die Antworten auf geschlossene Fragen sind viele Antwortoptionen in den Umfragen des Pew Research Center so programmiert, dass sie randomisiert werden, um sicherzustellen, dass die Optionen nicht für jeden Befragten in derselben Reihenfolge gestellt werden. Rotieren oder Randomisieren bedeutet, dass Fragen oder Elemente in einer Liste nicht in derselben Reihenfolge an jeden Befragten gestellt werden. Antworten auf Fragen werden manchmal von Fragen beeinflusst, die ihnen vorausgehen. Indem wir jedem Befragten Fragen in einer anderen Reihenfolge stellen, stellen wir sicher, dass jede Frage im selben Kontext wie jede andere Frage gleich oft gestellt wird (z. B. erste, letzte oder eine beliebige Position dazwischen). Dies beseitigt nicht die potenziellen Auswirkungen früherer Fragen auf die aktuelle Frage, stellt jedoch sicher, dass diese Verzerrung zufällig auf alle Fragen oder Elemente in der Liste verteilt wird. Zum Beispiel wurde in dem oben diskutierten Beispiel, welches Thema bei der Abstimmung am wichtigsten war, die Reihenfolge der fünf Probleme in der geschlossenen Version der Frage randomisiert, so dass kein Problem für alle Befragten früh oder spät in der Liste erschien. Die Randomisierung von Antwortelementen beseitigt keine Ordnungseffekte, stellt jedoch sicher, dass diese Art von Verzerrung zufällig verteilt wird.

Fragen mit ordinalen Antwortkategorien – solche mit einer zugrunde liegenden Reihenfolge (z. B. ausgezeichnet, gut, nur fair, schlecht ODER sehr günstig, meist günstig, meist ungünstig, sehr ungünstig) – werden im Allgemeinen nicht randomisiert, da die Reihenfolge der Kategorien wichtige Informationen vermittelt, die den Befragten bei der Beantwortung der Frage helfen. Im Allgemeinen sollten diese Arten von Skalen der Reihe nach dargestellt werden, damit die Befragten ihre Antworten leicht entlang des Kontinuums platzieren können. Zum Beispiel, in einer der Fragen des Pew Research Center zur Abtreibung, Die Hälfte der Stichprobe wird gefragt, ob Abtreibung „in allen Fällen legal sein sollte, legal in den meisten Fällen, illegal in den meisten Fällen, illegal in allen Fällen,Während die andere Hälfte der Stichprobe die gleiche Frage gestellt wird, wobei die Antwortkategorien in umgekehrter Reihenfolge gelesen werden, beginnend mit „in allen Fällen illegal.“ Auch hier beseitigt die Umkehrung der Reihenfolge den Aktualitätseffekt nicht, sondern verteilt ihn zufällig auf die Bevölkerung.

Fragenwortlaut

Die Wahl der Wörter und Sätze in einer Frage ist entscheidend, um dem Befragten die Bedeutung und Absicht der Frage auszudrücken und sicherzustellen, dass alle Befragten die Frage auf die gleiche Weise interpretieren. Selbst kleine Formulierungsunterschiede können die Antworten der Menschen erheblich beeinflussen.

Ein Beispiel für einen Formulierungsunterschied, der einen signifikanten Einfluss auf die Antworten hatte, stammt aus einer Umfrage des Pew Research Center vom Januar 2003. Auf die Frage, ob sie „eine militärische Aktion im Irak zur Beendigung der Herrschaft Saddam Husseins befürworten oder ablehnen“ würden, gaben 68% an, dass sie eine militärische Aktion befürworten, während 25% eine militärische Aktion ablehnten. Auf die Frage, ob sie „eine militärische Aktion im Irak zur Beendigung der Herrschaft Saddam Husseins befürworten oder ablehnen würden, selbst wenn dies bedeuten würde, dass die US-Streitkräfte Tausende von Opfern erleiden könnten“, waren die Antworten dramatisch unterschiedlich; Nur 43% sagten, sie befürworteten eine militärische Aktion, während 48% sagten, sie seien dagegen. Die Einführung von U.S. verluste veränderten den Kontext der Frage und beeinflussten, ob die Menschen militärische Aktionen im Irak befürworteten oder ablehnten.

Es gab eine beträchtliche Menge an Forschung, um die Auswirkungen verschiedener Arten von Fragen zu messen und Unterschiede in der Art und Weise zu minimieren, wie die Befragten interpretieren, was gefragt wird. Die Probleme im Zusammenhang mit der Formulierung von Fragen sind zahlreicher, als in diesem kurzen Raum angemessen behandelt werden können, Im Folgenden sind jedoch einige wichtige Dinge zu beachten:

Zunächst ist es wichtig, klare und spezifische Fragen zu stellen, die jeder Befragte beantworten kann. Wenn eine Frage offen ist, sollte den Befragten klar sein, dass sie in ihren eigenen Worten antworten können und welche Art von Antwort sie geben sollten (ein Problem oder Problem, ein Monat, Anzahl der Tage usw.). Geschlossene Fragen sollten alle vernünftigen Antworten enthalten (d. h. die Liste der Optionen ist vollständig) und die Antwortkategorien sollten sich nicht überschneiden (d. h. die Antwortoptionen sollten sich gegenseitig ausschließen). Darüber hinaus ist es wichtig zu erkennen, wann es am besten ist, geschlossene Fragen mit erzwungener Auswahl (in Online-Umfragen häufig mit einem Optionsfeld gekennzeichnet) im Vergleich zu „Alles auswählen, was zutrifft“ -Listen (oder Kontrollkästchen) zu verwenden. Eine Center-Studie aus dem Jahr 2019 ergab, dass Forced-Choice-Fragen tendenziell genauere Antworten liefern, insbesondere bei sensiblen Fragen. Basierend auf dieser Forschung vermeidet das Zentrum im Allgemeinen die Verwendung von Select-all-that-Apply-Fragen.

Es ist auch wichtig, jeweils nur eine Frage zu stellen. Fragen, bei denen die Befragten aufgefordert werden, mehr als ein Konzept zu bewerten (sogenannte doppelläufige Fragen) – wie „Wie viel Vertrauen haben Sie in Präsident Obama, um mit der Innen– und Außenpolitik umzugehen?“ – sind für die Befragten schwer zu beantworten und führen oft zu schwer zu interpretierenden Antworten. In diesem Beispiel wäre es effektiver, zwei getrennte Fragen zu stellen, eine zur Innenpolitik und eine zur Außenpolitik.

Im Allgemeinen werden Fragen, die eine einfache und konkrete Sprache verwenden, von den Befragten leichter verstanden. Es ist besonders wichtig, das Bildungsniveau der Umfrageteilnehmer zu berücksichtigen, wenn Sie darüber nachdenken, wie einfach es für die Befragten ist, eine Frage zu interpretieren und zu beantworten. Doppelte Negative (z. B. befürworten oder lehnen Sie es ab, Schwulen und Lesben nicht zu erlauben, legal zu heiraten) oder unbekannte Abkürzungen oder Jargon (z. B. ANWR anstelle des Arctic National Wildlife Refuge) können zu Verwirrung bei den Befragten führen und sollten vermieden werden.

Ebenso ist es wichtig zu prüfen, ob bestimmte Wörter für einige Befragte als voreingenommen oder potenziell beleidigend angesehen werden können, sowie die emotionale Reaktion, die einige Wörter hervorrufen können. In einer Umfrage des Pew Research Center aus dem Jahr 2005 gaben 51% der Befragten an, dass sie „es für Ärzte legal machen, unheilbar kranken Patienten die Mittel zu geben, ihr Leben zu beenden“, aber nur 44% gaben an, dass sie „es für Ärzte legal machen, unheilbar kranken Patienten beim Selbstmord zu helfen“.“ Obwohl beide Versionen der Frage nach dem gleichen fragen, war die Reaktion der Befragten unterschiedlich. In einem anderen Beispiel, Die Befragten haben unterschiedlich auf Fragen reagiert, bei denen das Wort „Wohlfahrt“ im Gegensatz zum allgemeineren „Hilfe für die Armen“ verwendet wurde.“ Mehrere Experimente haben gezeigt, dass die öffentliche Unterstützung für die Ausweitung der „Hilfe für die Armen“ viel größer ist als für die Ausweitung der „Wohlfahrt“.“

Wir schreiben oft zwei Versionen einer Frage und stellen der Hälfte der Umfragestichprobe eine Version der Frage und der anderen Hälfte die zweite Version. Wir sagen also, wir haben zwei Formen des Fragebogens. Die Befragten werden nach dem Zufallsprinzip zugewiesen, um beide Formulare zu erhalten, sodass wir davon ausgehen können, dass die beiden Gruppen von Befragten im Wesentlichen identisch sind. Bei Fragen, bei denen zwei Versionen verwendet werden, zeigen signifikante Unterschiede in den Antworten zwischen den beiden Formen, dass der Unterschied auf die Art und Weise zurückzuführen ist, wie wir die beiden Versionen formuliert haben.

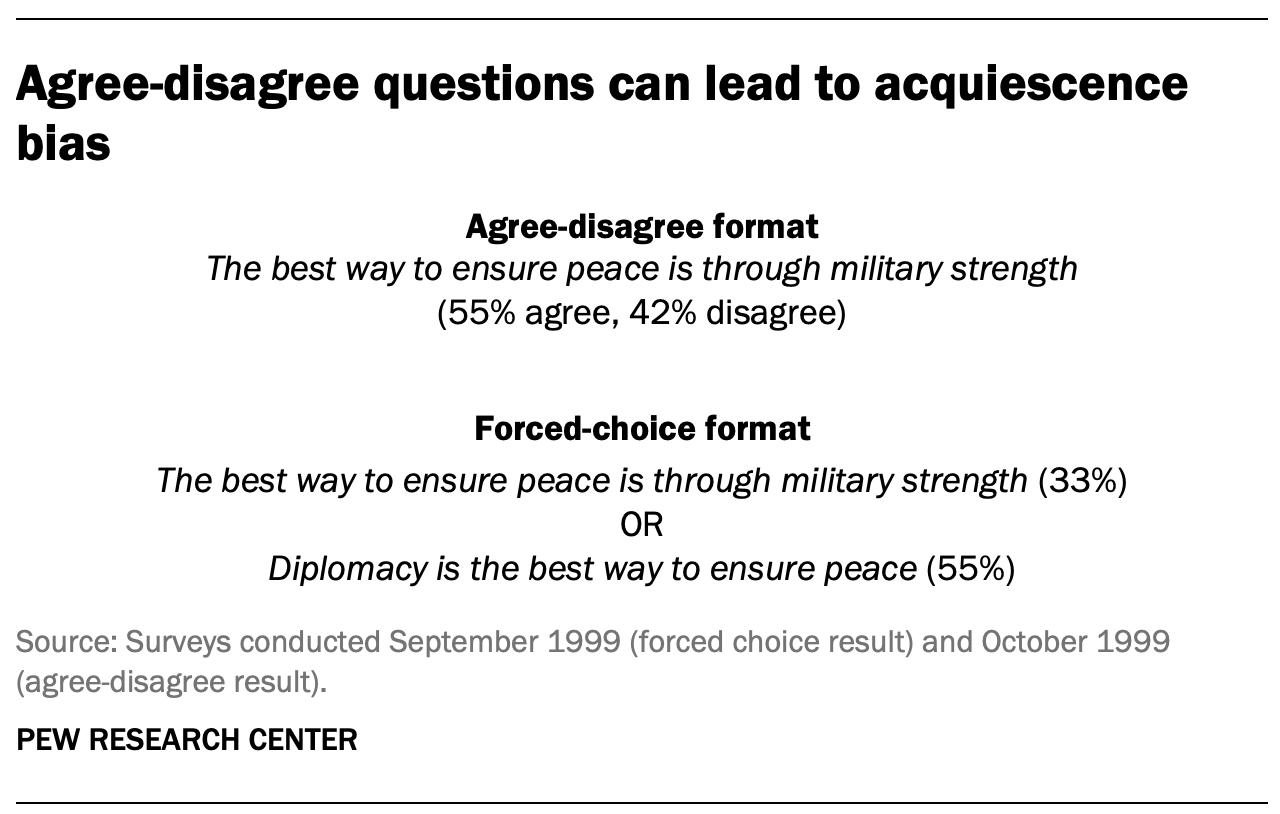

Eines der am häufigsten in Umfragefragen verwendeten Formate ist das Format „Zustimmen-nicht zustimmen“. In dieser Art von Frage werden die Befragten gefragt, ob sie einer bestimmten Aussage zustimmen oder nicht. Untersuchungen haben gezeigt, dass weniger gebildete und weniger informierte Befragte im Vergleich zu besser ausgebildeten und besser informierten Befragten eher dazu neigen, solchen Aussagen zuzustimmen. Dies wird manchmal als „Duldungsverzerrung“ bezeichnet (da einige Arten von Befragten der Behauptung eher zustimmen als andere). Dieses Verhalten ist noch ausgeprägter, wenn ein Interviewer anwesend ist, als wenn die Umfrage selbst verwaltet wird. Eine bessere Praxis besteht darin, den Befragten die Wahl zwischen alternativen Aussagen zu bieten. Ein Experiment des Pew Research Center mit einer seiner routinemäßig gestellten Wertefragen veranschaulicht den Unterschied, den das Fragenformat machen kann. Das Forced Choice-Format liefert nicht nur insgesamt ein sehr anderes Ergebnis als das Agree-Disagree-Format, sondern auch das Muster der Antworten zwischen Befragten mit mehr oder weniger formaler Bildung ist tendenziell sehr unterschiedlich.

Eine weitere Herausforderung bei der Entwicklung von Fragebögen ist das sogenannte „Social Desirability Bias“.“ Menschen haben eine natürliche Tendenz, akzeptiert und gemocht werden zu wollen, und dies kann dazu führen, dass Menschen ungenaue Antworten auf Fragen geben, die sich mit sensiblen Themen befassen. Untersuchungen haben gezeigt, dass die Befragten Alkohol- und Drogenkonsum, Steuerhinterziehung und rassistische Vorurteile unterschätzen. Sie können auch den Kirchenbesuch, Wohltätigkeitsbeiträge und die Wahrscheinlichkeit, dass sie an einer Wahl teilnehmen, übertreiben. Die Forscher versuchen, diese potenzielle Verzerrung bei der Erstellung von Fragen zu diesen Themen zu berücksichtigen. Wenn zum Beispiel Umfragen des Pew Research Center nach dem Wahlverhalten in der Vergangenheit fragen, ist es wichtig zu beachten, dass die Umstände den Befragten möglicherweise daran gehindert haben zu wählen: „Sind bei den Präsidentschaftswahlen 2012 zwischen Barack Obama und Mitt Romney Dinge aufgetaucht, die Sie davon abgehalten haben zu wählen, oder haben Sie zufällig gewählt?“ Die Wahl der Antwortoptionen kann es den Menschen auch erleichtern, ehrlich zu sein. Eine Frage zum Kirchenbesuch kann beispielsweise drei von sechs Antwortoptionen enthalten, die auf einen seltenen Besuch hinweisen. Untersuchungen haben auch gezeigt, dass die Verzerrung der sozialen Erwünschtheit größer sein kann, wenn ein Interviewer anwesend ist (z. B. Telefon- und persönliche Umfragen), als wenn die Befragten die Umfrage selbst ausfüllen (z. B. Papier- und Webumfragen).

Da geringfügige Änderungen der Fragenformulierung die Antworten beeinflussen können, sollten identische Fragenformulierungen verwendet werden, wenn die Ergebnisse mit denen früherer Umfragen verglichen werden sollen. Da der Wortlaut und die Antworten der Fragen je nach dem für die Befragung der Befragten verwendeten Modus variieren können, sollten die Forscher die wahrscheinlichen Auswirkungen auf die Trendmessungen sorgfältig abwägen, wenn ein anderer Umfragemodus verwendet wird, um Meinungsänderungen im Laufe der Zeit zu bewerten.

Fragenreihenfolge

Sobald die Umfragefragen entwickelt sind, sollte besonders darauf geachtet werden, wie sie im Fragebogen angeordnet sind. Vermessungsingenieure müssen darauf achten, dass Fragen zu Beginn eines Fragebogens unbeabsichtigte Auswirkungen auf die Beantwortung nachfolgender Fragen durch die Befragten haben können. Forscher haben gezeigt, dass die Reihenfolge, in der Fragen gestellt werden, beeinflussen kann, wie Menschen reagieren; Frühere Fragen können unbeabsichtigt einen Kontext für die folgenden Fragen bieten (diese Effekte werden als „Ordnungseffekte“ bezeichnet).

Eine Art von Ordnungseffekt kann in Antworten auf offene Fragen gesehen werden. Umfragen des Pew Research Center stellen in der Regel zu Beginn des Fragebogens offene Fragen zu nationalen Problemen, Meinungen zu Führungskräften und ähnlichen Themen. Wenn geschlossene Fragen, die sich auf das Thema beziehen, vor die offene Frage gestellt werden, Erwähnen die Befragten viel häufiger Konzepte oder Überlegungen, die in diesen früheren Fragen aufgeworfen wurden, wenn sie auf die offene Frage antworten.

Für geschlossene Meinungsfragen gibt es zwei Haupttypen von Ordnungseffekten: Kontrasteffekte (bei denen die Reihenfolge zu größeren Unterschieden in den Antworten führt) und Assimilationseffekte (bei denen die Antworten aufgrund ihrer Reihenfolge ähnlicher sind).

Ein Beispiel für einen Kontrasteffekt ist eine Umfrage des Pew Research Center, die im Oktober 2003 durchgeführt wurde, ein Dutzend Jahre bevor die gleichgeschlechtliche Ehe in den USA legalisiert wurde. Diese Umfrage ergab, dass die Menschen eher dafür waren, schwulen und Lesben zu erlauben, rechtliche Vereinbarungen zu treffen, die ihnen die gleichen Rechte wie verheiratete Paare einräumen, wenn diese Frage nach einer Frage gestellt wurde, ob sie Schwule und Lesben bevorzugen oder ablehnen heiraten (45% bevorzugten rechtliche Vereinbarungen, wenn sie nach der Heiratsfrage gefragt wurden, aber 37% bevorzugten rechtliche Vereinbarungen ohne den unmittelbaren vorhergehenden Kontext einer Frage zur gleichgeschlechtlichen Ehe). Die Antworten auf die Frage nach der gleichgeschlechtlichen Ehe wurden durch ihre Platzierung vor oder nach der fraglichen rechtlichen Vereinbarung nicht wesentlich beeinflusst.

Ein weiteres Experiment, das in eine Umfrage des Pew Research Center vom Dezember 2008 eingebettet war, führte ebenfalls zu einem Kontrasteffekt. Als die Leute gefragt wurden: „Alles in allem, sind Sie zufrieden oder unzufrieden mit der Art und Weise, wie die Dinge heute in diesem Land laufen?“ unmittelbar nachdem Sie gefragt wurden: „Billigen oder missbilligen Sie die Art und Weise, wie George W. Bush mit seinem Job als Präsident umgeht?“; 88% gaben an, unzufrieden zu sein, verglichen mit nur 78% ohne den Kontext der vorherigen Frage.

Die Antworten auf die Zustimmung des Präsidenten blieben relativ unverändert, unabhängig davon, ob die nationale Zufriedenheit zuvor oder danach gefragt wurde. Ein ähnlicher Befund trat im Dezember 2004 auf, als sowohl die Zufriedenheit als auch die Zustimmung des Präsidenten viel höher waren (57% waren unzufrieden, als die Zustimmung von Bush zuerst gefragt wurde, gegenüber 51%, als die allgemeine Zufriedenheit zuerst gefragt wurde).

Mehrere Studien haben auch gezeigt, dass das Stellen einer spezifischeren Frage vor einer allgemeineren Frage (z., nach dem Glück mit der Ehe zu fragen, bevor man nach dem allgemeinen Glück fragt) kann zu einem Kontrasteffekt führen. Obwohl einige Ausnahmen gefunden wurden, neigen Menschen dazu, Redundanz zu vermeiden, indem sie die spezifischere Frage von der allgemeinen Bewertung ausschließen.

Assimilationseffekte treten auf, wenn die Antworten auf zwei Fragen aufgrund ihrer Platzierung im Fragebogen konsistenter oder näher beieinander liegen. Wir fanden ein Beispiel für einen Assimilationseffekt in einer Umfrage des Pew Research Center, die im November 2008 durchgeführt wurde, als wir fragten, ob republikanische Führer mit Obama zusammenarbeiten oder sich in wichtigen Fragen gegen ihn stellen sollten und ob demokratische Führer mit republikanischen Führern zusammenarbeiten oder sich in wichtigen Fragen gegen sie stellen sollten. Die Leute sagten eher, dass republikanische Führer mit Obama zusammenarbeiten sollten, wenn der Frage die Frage vorausging, was demokratische Führer bei der Zusammenarbeit mit republikanischen Führern tun sollten (81% vs. 66%). Als die Leute jedoch zum ersten Mal nach republikanischen Führern gefragt wurden, die mit Obama zusammenarbeiten, sagten weniger, dass demokratische Führer mit republikanischen Führern zusammenarbeiten sollten (71% gegenüber 82%).

Die Reihenfolge Fragen gestellt werden, ist von besonderer Bedeutung, wenn Trends im Laufe der Zeit zu verfolgen. Daher sollte darauf geachtet werden, dass der Kontext jedes Mal ähnlich ist, wenn eine Frage gestellt wird. Das Ändern des Kontexts der Frage kann alle beobachteten Änderungen im Laufe der Zeit in Frage stellen (weitere Informationen finden Sie unter Messen der Änderung im Laufe der Zeit).

Ein Fragebogen sollte wie eine Konversation nach Themen gruppiert werden und in einer logischen Reihenfolge ablaufen. Es ist oft hilfreich, die Umfrage mit einfachen Fragen zu beginnen, die die Befragten interessant und ansprechend finden. Während der gesamten Umfrage sollte versucht werden, die Umfrage interessant zu halten und die Befragten nicht mit mehreren schwierigen Fragen direkt hintereinander zu überlasten. Demografische Fragen wie Einkommen, Bildung oder Alter sollten nicht zu Beginn einer Umfrage gestellt werden, es sei denn, sie werden benötigt, um die Berechtigung für die Umfrage zu bestimmen oder die Befragten durch bestimmte Abschnitte des Fragebogens zu leiten. Selbst dann ist es am besten, solchen Elementen interessantere und einnehmendere Fragen vorauszugehen. Eine Tugend von Umfrage-Panels wie dem ATP ist, dass demografische Fragen in der Regel nur einmal im Jahr gestellt werden müssen, nicht in jeder Umfrage.