Statistische Analyse bedeutet, Trends, Muster und Beziehungen anhand quantitativer Daten zu untersuchen. Es ist ein wichtiges Forschungsinstrument, das von Wissenschaftlern, Regierungen, Unternehmen und anderen Organisationen eingesetzt wird.

Um valide Schlussfolgerungen zu ziehen, erfordert die statistische Analyse von Anfang an eine sorgfältige Planung des Forschungsprozesses. Sie müssen Ihre Hypothesen angeben und Entscheidungen über Ihr Forschungsdesign, Ihre Stichprobengröße und Ihr Stichprobenverfahren treffen.

Nachdem Sie Daten aus Ihrer Stichprobe gesammelt haben, können Sie die Daten mithilfe von deskriptiven Statistiken organisieren und zusammenfassen. Anschließend können Sie Inferenzstatistiken verwenden, um Hypothesen formal zu testen und Schätzungen über die Grundgesamtheit vorzunehmen. Schließlich können Sie Ihre Ergebnisse interpretieren und verallgemeinern.

Dieser Artikel ist eine praktische Einführung in die statistische Analyse für Studenten und Forscher. Wir führen Sie anhand von zwei Forschungsbeispielen durch die Schritte. Die erste untersucht eine mögliche Ursache-Wirkungs-Beziehung, während die zweite eine mögliche Korrelation zwischen Variablen untersucht.

Schritt 1: Schreiben Sie Ihre Hypothesen und planen Sie Ihr Forschungsdesign

Um gültige Daten für die statistische Analyse zu sammeln, müssen Sie zuerst Ihre Hypothesen angeben und Ihr Forschungsdesign planen.

Schreiben statistischer Hypothesen

Das Ziel der Forschung ist es oft, eine Beziehung zwischen Variablen innerhalb einer Population zu untersuchen. Sie beginnen mit einer Vorhersage und verwenden statistische Analysen, um diese Vorhersage zu testen.

Eine statistische Hypothese ist eine formale Art, eine Vorhersage über eine Population zu schreiben. Jede Forschungsvorhersage wird in Null- und Alternativhypothesen umformuliert, die anhand von Beispieldaten getestet werden können.

Während die Nullhypothese immer keinen Effekt oder keine Beziehung zwischen Variablen vorhersagt, gibt die Alternativhypothese Ihre Forschungsvorhersage eines Effekts oder einer Beziehung an.

- Nullhypothese: Eine 5-minütige Meditationsübung hat keinen Einfluss auf die mathematischen Testergebnisse bei Teenagern.

- Alternative Hypothese: Eine 5-minütige Meditationsübung verbessert die mathematischen Testergebnisse bei Teenagern.

- Nullhypothese: Elterneinkommen und GPA stehen bei College-Studenten in keiner Beziehung zueinander.

- Alternativhypothese: Elterneinkommen und GPA sind bei College-Studenten positiv korreliert.

Planung Ihres Forschungsdesigns

Ein Forschungsdesign ist Ihre Gesamtstrategie für die Datenerfassung und -analyse. Es bestimmt die statistischen Tests, mit denen Sie Ihre Hypothese später testen können.

Entscheiden Sie zunächst, ob Ihre Forschung ein deskriptives, korrelatives oder experimentelles Design verwendet. Experimente beeinflussen Variablen direkt, während deskriptive und korrelative Studien nur Variablen messen.

- In einem experimentellen Design können Sie eine Ursache-Wirkungs-Beziehung (z. B. die Wirkung von Meditation auf Testergebnisse) mithilfe statistischer Vergleichs- oder Regressionstests bewerten.

- In einem Korrelationsdesign können Sie Beziehungen zwischen Variablen untersuchen (z., Elterneinkommen und GPA) ohne Annahme einer Kausalität unter Verwendung von Korrelationskoeffizienten und Signifikanztests.

- In einem deskriptiven Design können Sie die Merkmale einer Population oder eines Phänomens (z. B. die Prävalenz von Angstzuständen bei US-College-Studenten) mithilfe statistischer Tests untersuchen, um Rückschlüsse aus Beispieldaten zu ziehen.

Ihr Forschungsdesign betrifft auch, ob Sie Teilnehmer auf Gruppen- oder Einzelebene oder beides vergleichen.

- In einem Design zwischen den Probanden vergleichen Sie die Ergebnisse auf Gruppenebene von Teilnehmern, die verschiedenen Behandlungen ausgesetzt waren (z. B. diejenigen, die eine Meditationsübung durchgeführt haben, und diejenigen, die dies nicht getan haben).

- In einem Design innerhalb der Probanden vergleichen Sie wiederholte Messungen von Teilnehmern, die an allen Behandlungen einer Studie teilgenommen haben (z. B. Scores vor und nach der Durchführung einer Meditationsübung).

- Experimentell

- Korrelativ

Zuerst nehmen Sie Baseline-Testergebnisse von Teilnehmern. Anschließend werden Ihre Teilnehmer einer 5-minütigen Meditationsübung unterzogen. Schließlich zeichnen Sie die Ergebnisse der Teilnehmer aus einem zweiten Mathematiktest auf.

In diesem Experiment ist die unabhängige Variable die 5-minütige Meditationsübung, und die abhängige Variable ist die Änderung der mathematischen Testergebnisse vor und nach der Intervention.

In dieser Studie gibt es keine abhängigen oder unabhängigen Variablen, da Sie nur Variablen messen möchten, ohne sie in irgendeiner Weise zu beeinflussen.

Messvariablen

Bei der Planung eines Forschungsdesigns sollten Sie Ihre Variablen operationalisieren und genau entscheiden, wie Sie sie messen möchten.

Für die statistische Analyse ist es wichtig, den Grad der Messung Ihrer Variablen zu berücksichtigen, der Ihnen sagt, welche Art von Daten sie enthalten:

- Kategoriale Daten stellen Gruppierungen dar. Diese können nominal (z.B., Geschlecht) oder ordinal (z.B. Sprachniveau).

- Quantitative Daten stellen Beträge dar. Diese können auf einer Intervallskala (z. B. Testergebnis) oder einer Verhältnisskala (z. B. Alter) liegen.

Viele Variablen können mit unterschiedlicher Genauigkeit gemessen werden. Zum Beispiel können Altersdaten quantitativ (8 Jahre alt) oder kategorisch (jung) sein. Wenn eine Variable numerisch codiert ist (z. B. Übereinstimmungsgrad von 1-5), bedeutet dies nicht automatisch, dass sie quantitativ statt kategorisch ist.

Die Identifizierung des Messniveaus ist wichtig für die Auswahl geeigneter Statistiken und Hypothesentests. Sie können beispielsweise einen Mittelwert mit quantitativen Daten berechnen, jedoch nicht mit kategorialen Daten.

In einer Forschungsstudie sammeln Sie zusammen mit Messungen Ihrer interessierenden Variablen häufig Daten zu relevanten Teilnehmermerkmalen.

- Experimentell

- Korrelativ

| Variable | Art der Daten |

|---|---|

| Alter | Quantitativ (Verhältnis) |

| Geschlecht | Kategorisch (nominal) |

| Rasse oder ethnische Zugehörigkeit | Kategorisch (nominal) |

| Baseline-Testergebnisse | Quantitativ (Intervall) |

| Endgültige Testergebnisse | Quantitativ (Intervall) |

| Variable | Art der Daten |

|---|---|

| Elterneinkommen | Quantitativ (Verhältnis) |

| GPA | Quantitativ (Intervall) |

Schritt 2: Sammeln von Daten aus einer Stichprobe

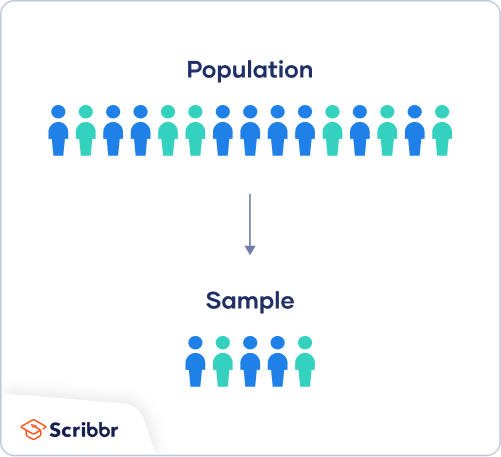

In den meisten Fällen ist es zu schwierig oder zu teuer, Daten von jedem Mitglied der Bevölkerung zu sammeln, an dem Sie interessiert sind. Stattdessen sammeln Sie Daten aus einer Stichprobe.

Mit der statistischen Analyse können Sie Ihre Ergebnisse über Ihre eigene Stichprobe hinaus anwenden, sofern Sie geeignete Stichprobenverfahren anwenden. Sie sollten eine Stichprobe anstreben, die für die Bevölkerung repräsentativ ist.

Stichprobe für die statistische Analyse

Es gibt zwei Hauptansätze zur Auswahl einer Stichprobe.

- Wahrscheinlichkeitsstichprobe: Jedes Mitglied der Bevölkerung hat die Chance, durch Zufallsauswahl für die Studie ausgewählt zu werden.

- Nicht-Wahrscheinlichkeitsstichprobe: Einige Mitglieder der Bevölkerung werden aufgrund von Kriterien wie Bequemlichkeit oder freiwilliger Selbstauswahl eher für die Studie ausgewählt als andere.

Theoretisch sollten Sie für stark verallgemeinerbare Ergebnisse eine Wahrscheinlichkeitsstichprobenmethode verwenden. Die zufällige Auswahl verringert die Verzerrung der Stichprobe und stellt sicher, dass die Daten aus Ihrer Stichprobe tatsächlich typisch für die Grundgesamtheit sind. Parametrische Tests können verwendet werden, um starke statistische Schlussfolgerungen zu ziehen, wenn Daten mithilfe von Wahrscheinlichkeitsstichproben gesammelt werden.

In der Praxis ist es jedoch selten möglich, die ideale Probe zu entnehmen. Während Nicht-Wahrscheinlichkeitsstichproben eher voreingenommen sind, sind sie viel einfacher zu rekrutieren und Daten zu sammeln. Nichtparametrische Tests eignen sich eher für Stichproben ohne Wahrscheinlichkeit, führen jedoch zu schwächeren Schlussfolgerungen über die Grundgesamtheit.

Wenn Sie parametrische Tests für Nichtwahrscheinlichkeitsstichproben verwenden möchten, müssen Sie Folgendes tun:

- ihre Stichprobe ist repräsentativ für die Population, auf die Sie Ihre Ergebnisse verallgemeinern.

- Ihre Stichprobe weist keine systematische Verzerrung auf.

Denken Sie daran, dass externe Validität bedeutet, dass Sie Ihre Schlussfolgerungen nur für andere verallgemeinern können, die die Eigenschaften Ihrer Stichprobe teilen. Zum Beispiel Ergebnisse aus westlichen, gebildeten, industrialisierten, reichen und demokratischen Stichproben (z., College-Studenten in den USA) gelten nicht automatisch für alle Nicht-COLLEGE-Populationen.

Wenn Sie parametrische Tests auf Daten aus Nichtwahrscheinlichkeitsstichproben anwenden, sollten Sie in Ihrem Diskussionsabschnitt die Einschränkungen erläutern, inwieweit Ihre Ergebnisse verallgemeinert werden können.

Erstellen Sie ein geeignetes Stichprobenverfahren

Entscheiden Sie auf der Grundlage der für Ihre Forschung verfügbaren Ressourcen, wie Sie Teilnehmer rekrutieren möchten.

- Haben Sie Ressourcen, um Ihr Studium auch außerhalb Ihrer Universität zu bewerben?

- Haben Sie die Mittel, eine vielfältige Stichprobe zu rekrutieren, die eine breite Bevölkerung repräsentiert?

- Haben Sie Zeit, Mitglieder schwer erreichbarer Gruppen zu kontaktieren und zu verfolgen?

- Experimentell

- Korrelativ

Ihre Teilnehmer werden von ihren Schulen selbst ausgewählt. Obwohl Sie eine nicht wahrscheinliche Stichprobe verwenden, streben Sie eine vielfältige und repräsentative Stichprobe an.

Ihre Teilnehmer melden sich freiwillig für die Umfrage, sodass es sich um eine nicht wahrscheinliche Stichprobe handelt.

Berechnen Sie eine ausreichende Stichprobengröße

Bevor Sie Teilnehmer rekrutieren, entscheiden Sie sich für Ihre Stichprobengröße, indem Sie sich entweder andere Studien in Ihrem Bereich ansehen oder Statistiken verwenden. Eine zu kleine Stichprobe ist möglicherweise nicht repräsentativ für die Stichprobe, während eine zu große Stichprobe teurer als erforderlich ist.

Es gibt viele Stichprobengrößenrechner online. Je nachdem, ob Sie Untergruppen haben oder wie streng Ihre Studie sein sollte (z. B. in der klinischen Forschung), werden unterschiedliche Formeln verwendet. Als Faustregel gilt, dass mindestens 30 Einheiten pro Untergruppe erforderlich sind.

Um diese Taschenrechner verwenden zu können, müssen Sie diese Schlüsselkomponenten verstehen und eingeben:

- Signifikanzniveau (Alpha): Das Risiko, eine echte Nullhypothese abzulehnen, die Sie annehmen möchten, wird normalerweise auf 5% festgelegt.

- Statistische Potenz: Die Wahrscheinlichkeit, dass Ihre Studie einen Effekt einer bestimmten Größe erkennt, falls vorhanden, normalerweise 80% oder höher.

- Erwartete Effektgröße: eine standardisierte Angabe, wie groß das erwartete Ergebnis Ihrer Studie sein wird, normalerweise basierend auf anderen ähnlichen Studien.

- Populationsstandardabweichung: Eine Schätzung des Populationsparameters basierend auf einer früheren Studie oder einer eigenen Pilotstudie.

Schritt 3: Fassen Sie Ihre Daten mit deskriptiven Statistiken zusammen

Sobald Sie alle Ihre Daten gesammelt haben, können Sie sie überprüfen und deskriptive Statistiken berechnen, die sie zusammenfassen.

Überprüfen Sie Ihre Daten

Es gibt verschiedene Möglichkeiten, Ihre Daten zu überprüfen, darunter die folgenden:

- Organisieren von Daten aus jeder Variablen in Häufigkeitsverteilungstabellen.

- Anzeigen von Daten aus einer Schlüsselvariablen in einem Balkendiagramm, um die Verteilung der Antworten anzuzeigen.

- Visualisierung der Beziehung zwischen zwei Variablen mithilfe eines Streudiagramms.

Durch die Visualisierung Ihrer Daten in Tabellen und Diagrammen können Sie beurteilen, ob Ihre Daten einer schiefen oder normalen Verteilung folgen und ob es Ausreißer oder fehlende Daten gibt.

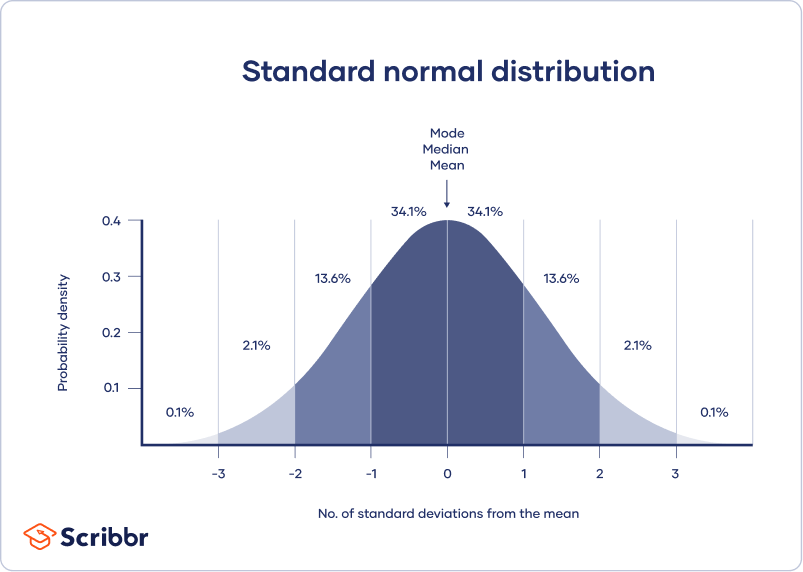

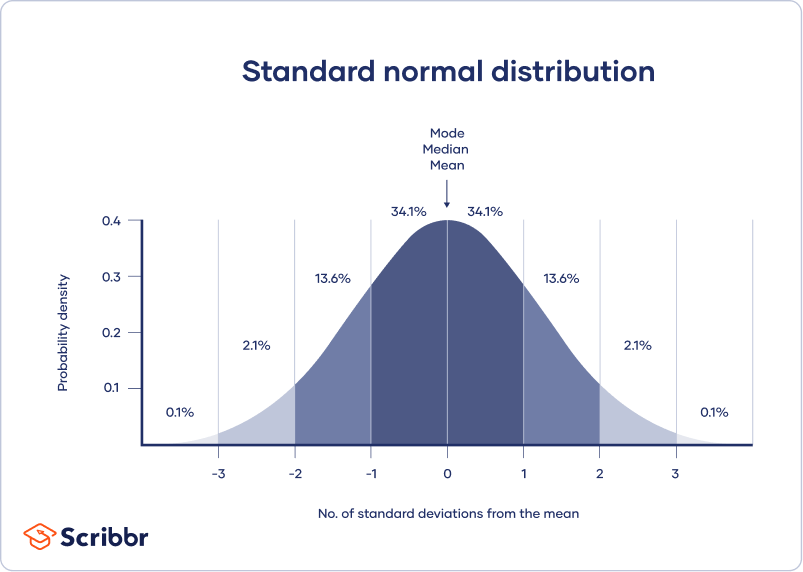

Eine Normalverteilung bedeutet, dass Ihre Daten symmetrisch um ein Zentrum verteilt sind, in dem die meisten Werte liegen, wobei sich die Werte an den hinteren Enden verjüngen.

Im Gegensatz dazu ist eine schiefe Verteilung asymmetrisch und hat an einem Ende mehr Werte als am anderen. Die Form der Verteilung ist wichtig zu beachten, da nur einige deskriptive Statistiken mit verzerrten Verteilungen verwendet werden sollten.

Extreme Ausreißer können auch zu irreführenden Statistiken führen, sodass Sie möglicherweise einen systematischen Ansatz für den Umgang mit diesen Werten benötigen.

Zentrale Tendenzmaße berechnen

Zentrale Tendenzmaße beschreiben, wo die meisten Werte in einem Datensatz liegen. Drei Hauptmaße der zentralen Tendenz werden häufig berichtet:

- Modus: Die beliebteste Antwort oder der beliebteste Wert im Datensatz.

- Mittelwert: der Wert genau in der Mitte des Datensatzes, wenn er von niedrig nach hoch geordnet wird.

- Mittelwert: die Summe aller Werte geteilt durch die Anzahl der Werte.

Abhängig von der Form der Verteilung und dem Messniveau können jedoch nur eine oder zwei dieser Maßnahmen angemessen sein. Beispielsweise können viele demografische Merkmale nur mithilfe des Modus oder der Proportionen beschrieben werden, während eine Variable wie die Reaktionszeit möglicherweise überhaupt keinen Modus aufweist.

Variabilitätsmaße berechnen

Variabilitätsmaße geben an, wie verteilt die Werte in einem Datensatz sind. Vier Hauptmaße der Variabilität werden häufig berichtet:

- Bereich: der höchste Wert minus der niedrigste Wert des Datensatzes.

- Interquartilbereich: Der Bereich der mittleren Hälfte des Datensatzes.

- Standardabweichung: Der durchschnittliche Abstand zwischen jedem Wert in Ihrem Datensatz und dem Mittelwert.

- Varianz: das Quadrat der Standardabweichung.

Auch hier sollten die Form der Verteilung und das Maß der Messung Ihre Wahl der Variabilitätsstatistik bestimmen. Der Interquartilbereich ist das beste Maß für schiefe Verteilungen, während Standardabweichung und Varianz die besten Informationen für Normalverteilungen liefern.

- Experimentell

- Korrelativ

Anhand Ihrer Tabelle sollten Sie prüfen, ob die Einheiten der deskriptiven Statistik für Pretest- und Posttest-Scores vergleichbar sind. Sind beispielsweise die Varianzniveaus in den Gruppen ähnlich? Gibt es extreme Werte? In diesem Fall müssen Sie möglicherweise extreme Ausreißer in Ihrem Datensatz identifizieren und entfernen oder Ihre Daten transformieren, bevor Sie einen statistischen Test durchführen.

| Vortestergebnisse | Nachtestergebnisse | |

|---|---|---|

| Mittelwert | 68.44 | 75.25 |

| Standardabweichung | 9.43 | 9.88 |

| Varianz | 88.96 | 97.96 |

| Reichweite | 36.25 | 45.12 |

| N | 30 | |

Aus dieser Tabelle können wir sehen, dass der mittlere Wert nach der Meditationsübung anstieg und die Varianzen der beiden Werte vergleichbar sind. Als nächstes können wir einen statistischen Test durchführen, um herauszufinden, ob diese Verbesserung der Testergebnisse in der Population statistisch signifikant ist.

Es ist wichtig zu prüfen, ob Sie über eine breite Palette von Datenpunkten verfügen. Wenn Sie dies nicht tun, sind Ihre Daten möglicherweise mehr auf einige Gruppen ausgerichtet als auf andere (z. B. hohe akademische Leistungen), und es können nur begrenzte Rückschlüsse auf eine Beziehung gezogen werden.

| Elterneinkommen (USD) | GPA | |

|---|---|---|

| Mittelwert | 62,100 | 3.12 |

| Standardabweichung | 15,000 | 0.45 |

| Varianz | 225,000,000 | 0.16 |

| Reichweite | 8,000–378,000 | 2.64–4.00 |

| N | 653 | |

Als nächstes können wir einen Korrelationskoeffizienten berechnen und einen statistischen Test durchführen, um die Signifikanz der Beziehung zwischen den Variablen in der Grundgesamtheit zu verstehen.

Schritt 4: Testen Sie Hypothesen oder machen Sie Schätzungen mit Inferenzstatistiken

Eine Zahl, die eine Stichprobe beschreibt, wird als Statistik bezeichnet, während eine Zahl, die eine Grundgesamtheit beschreibt, als Parameter bezeichnet wird. Mithilfe von Inferenzstatistiken können Sie auf der Grundlage von Stichprobenstatistiken Rückschlüsse auf Populationsparameter ziehen.

Forscher verwenden häufig zwei Hauptmethoden (gleichzeitig), um Rückschlüsse auf Statistiken zu ziehen.

- Schätzung: Berechnung von Populationsparametern basierend auf Stichprobenstatistiken.

- Hypothesentests: ein formaler Prozess zum Testen von Forschungsvorhersagen über die Bevölkerung anhand von Stichproben.

Schätzung

Sie können zwei Arten von Schätzungen von Populationsparametern aus Stichprobenstatistiken vornehmen:

- Eine Punktschätzung: Ein Wert, der Ihre beste Schätzung des genauen Parameters darstellt.

- Eine Intervallschätzung: Ein Wertebereich, der Ihre beste Schätzung der Position des Parameters darstellt.

Wenn Sie Populationsmerkmale aus Stichprobendaten ableiten und melden möchten, verwenden Sie in Ihrer Arbeit am besten sowohl Punkt- als auch Intervallschätzungen.

Sie können eine Stichprobenstatistik als Punktschätzung für den Bevölkerungsparameter betrachten, wenn Sie eine repräsentative Stichprobe haben (z. B. wird in einer breiten öffentlichen Meinungsumfrage der Anteil einer Stichprobe, die die derzeitige Regierung unterstützt, als Bevölkerungsanteil der Regierungsanhänger angenommen).

Es gibt immer Fehler bei der Schätzung, daher sollten Sie auch ein Konfidenzintervall als Intervallschätzung angeben, um die Variabilität um eine Punktschätzung anzuzeigen.

Ein Konfidenzintervall verwendet den Standardfehler und den z-Wert aus der Standardnormalverteilung, um zu vermitteln, wo Sie im Allgemeinen erwarten würden, den Bevölkerungsparameter die meiste Zeit zu finden.

Testen von Hypothesen

Anhand von Daten aus einer Stichprobe können Sie Hypothesen über Beziehungen zwischen Variablen in der Grundgesamtheit testen. Hypothesentests beginnen mit der Annahme, dass die Nullhypothese in der Grundgesamtheit zutrifft, und Sie verwenden statistische Tests, um zu beurteilen, ob die Nullhypothese abgelehnt werden kann oder nicht.

Statistische Tests bestimmen, wo Ihre Stichprobendaten auf einer erwarteten Verteilung von Stichprobendaten liegen würden, wenn die Nullhypothese wahr wäre. Diese Tests ergeben zwei Hauptausgaben:

- Eine Teststatistik gibt an, wie stark sich Ihre Daten von der Nullhypothese des Tests unterscheiden.

- Ein p-Wert gibt an, mit welcher Wahrscheinlichkeit Sie Ihre Ergebnisse erhalten, wenn die Nullhypothese in der Grundgesamtheit tatsächlich zutrifft.

Statistische Tests gibt es in drei Hauptvarianten:

- Vergleichstests bewerten Gruppenunterschiede in den Ergebnissen.

- Regressionstests bewerten Ursache-Wirkungs-Beziehungen zwischen Variablen.

- Korrelationstests bewerten Beziehungen zwischen Variablen, ohne eine Kausalität anzunehmen.

Ihre Wahl des statistischen Tests hängt von Ihren Forschungsfragen, Ihrem Forschungsdesign, Ihrer Stichprobenmethode und Ihren Datenmerkmalen ab.

Parametrische Tests

Parametrische Tests ziehen anhand von Stichprobendaten aussagekräftige Rückschlüsse auf die Grundgesamtheit. Um sie zu verwenden, müssen jedoch einige Annahmen erfüllt sein, und es können nur einige Arten von Variablen verwendet werden. Wenn Ihre Daten gegen diese Annahmen verstoßen, können Sie stattdessen geeignete Datentransformationen durchführen oder alternative nichtparametrische Tests verwenden.

Eine Regression modelliert das Ausmaß, in dem Änderungen einer Prädiktorvariablen zu Änderungen der Ergebnisvariablen führen.

- Eine einfache lineare Regression enthält eine Prädiktorvariable und eine Ergebnisvariable.

- Eine multiple lineare Regression umfasst zwei oder mehr Prädiktorvariablen und eine Ergebnisvariable.

Vergleichstests vergleichen normalerweise die Mittelwerte von Gruppen. Dies können die Mittelwerte verschiedener Gruppen innerhalb einer Stichprobe sein (z. B. eine Behandlungs- und eine Kontrollgruppe), die Mittelwerte einer zu unterschiedlichen Zeiten entnommenen Stichprobengruppe (z. B. Pretest- und Posttest-Scores) oder ein Stichprobenmittelwert und ein Populationsmittelwert.

- Ein t-Test ist für genau 1 oder 2 Gruppen, wenn die Probe klein ist (30 oder weniger).

- Ein z-Test ist für genau 1 oder 2 Gruppen, wenn die Probe groß ist.

- Eine ANOVA ist für 3 oder mehr Gruppen.

Die z- und t-Tests haben Subtypen, die auf der Anzahl und Art der Proben und den Hypothesen basieren:

- Wenn Sie nur eine Stichprobe haben, die Sie mit einem Mittelwert der Grundgesamtheit vergleichen möchten, verwenden Sie einen Test mit einer Stichprobe.

- Wenn Sie Messungen gepaart haben (Design innerhalb der Probanden), verwenden Sie einen abhängigen (gepaarten) Stichprobentest.

- Wenn Sie völlig getrennte Messungen von zwei nicht übereinstimmenden Gruppen haben (Design zwischen Probanden), verwenden Sie einen unabhängigen Stichprobentest.

- Wenn Sie einen Unterschied zwischen Gruppen in einer bestimmten Richtung erwarten, verwenden Sie einen einseitigen Test.

- Wenn Sie keine Erwartungen an die Richtung eines Unterschieds zwischen Gruppen haben, verwenden Sie einen zweischwänzigen Test.

Der einzige parametrische Korrelationstest ist Pearsons r. Der Korrelationskoeffizient (r) gibt die Stärke einer linearen Beziehung zwischen zwei quantitativen Variablen an.

Um jedoch zu testen, ob die Korrelation in der Stichprobe stark genug ist, um in der Grundgesamtheit wichtig zu sein, müssen Sie auch einen Signifikanztest des Korrelationskoeffizienten durchführen, normalerweise einen t-Test, um einen p-Wert zu erhalten. Dieser Test verwendet den Stichprobenumfang, um zu berechnen, wie stark sich der Korrelationskoeffizient in der Grundgesamtheit von Null unterscheidet.

- Experimentell

- Korrelativ

Sie verwenden einen einseitigen T-Test mit abhängigen Stichproben, um zu beurteilen, ob die Meditationsübung die mathematischen Testergebnisse signifikant verbessert hat. Der Test gibt Ihnen:

- ein t-Wert (Teststatistik) von 3,00

- ein p-Wert von 0.0028

Obwohl Pearsons r eine Teststatistik ist, sagt es nichts darüber aus, wie signifikant die Korrelation in der Population ist. Sie müssen auch testen, ob dieser Stichprobenkorrelationskoeffizient groß genug ist, um eine Korrelation in der Grundgesamtheit nachzuweisen.

Ein t-Test kann auch bestimmen, wie signifikant sich ein Korrelationskoeffizient von Null unterscheidet, basierend auf der Stichprobengröße. Da Sie eine positive Korrelation zwischen dem elterlichen Einkommen und dem GPA erwarten, verwenden Sie einen One-Sample-One-Tailed-t-Test. Der t-Test gibt Ihnen:

- ein t-Wert von 3,08

- ein p-Wert von 0.001

Schritt 5: Interpretieren Sie Ihre Ergebnisse

Der letzte Schritt der statistischen Analyse ist die Interpretation Ihrer Ergebnisse.

Statistische Signifikanz

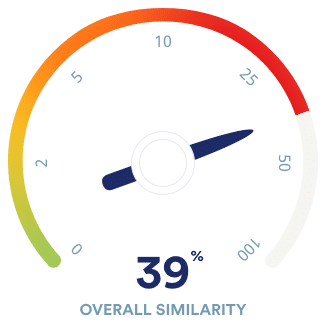

Bei Hypothesentests ist die statistische Signifikanz das Hauptkriterium für die Bildung von Schlussfolgerungen. Sie vergleichen Ihren p-Wert mit einem festgelegten Signifikanzniveau (normalerweise 0,05), um zu entscheiden, ob Ihre Ergebnisse statistisch signifikant oder nicht signifikant sind.

Statistisch signifikante Ergebnisse werden als unwahrscheinlich angesehen, dass sie ausschließlich zufällig entstanden sind. Es besteht nur eine sehr geringe Wahrscheinlichkeit, dass ein solches Ergebnis auftritt, wenn die Nullhypothese in der Grundgesamtheit zutrifft.

- Experimentell

- Korrelativ

Dies bedeutet, dass Sie glauben, dass die Meditationsintervention und nicht zufällige Faktoren direkt den Anstieg der Testergebnisse verursacht haben.

Beachten Sie, dass Korrelation nicht immer Kausalität bedeutet, da oft viele zugrunde liegende Faktoren zu einer komplexen Variablen wie dem GPA beitragen. Selbst wenn eine Variable mit einer anderen verwandt ist, kann dies an einer dritten Variablen liegen, die beide beeinflusst, oder an indirekten Verbindungen zwischen den beiden Variablen.

Eine große Stichprobengröße kann auch die statistische Signifikanz eines Korrelationskoeffizienten stark beeinflussen, indem sehr kleine Korrelationskoeffizienten signifikant erscheinen.

Effektgröße

Ein statistisch signifikantes Ergebnis bedeutet nicht unbedingt, dass es wichtige reale Anwendungen oder klinische Ergebnisse für einen Befund gibt.

Im Gegensatz dazu gibt die Effektgröße die praktische Bedeutung Ihrer Ergebnisse an. Es ist wichtig, Effektgrößen zusammen mit Ihren Inferenzstatistiken zu melden, um ein vollständiges Bild Ihrer Ergebnisse zu erhalten. Sie sollten auch Intervallschätzungen der Effektgrößen melden, wenn Sie ein Papier im APA-Stil schreiben.

- Experimentell

- Korrelativ

Mit einem Cohenschen d von 0.72, es gibt eine mittlere bis hohe praktische Bedeutung für Ihre Feststellung, dass die Meditationsübung die Testergebnisse verbessert hat.

Da Ihr Wert zwischen 0,1 und 0,3 liegt, stellt Ihr Befund einer Beziehung zwischen Elterneinkommen und GPA einen sehr geringen Effekt dar und hat eine begrenzte praktische Bedeutung.

Entscheidungsfehler

Typ-I- und Typ-II-Fehler sind Fehler, die in Forschungsschlussfolgerungen gemacht werden. Ein Fehler vom Typ I bedeutet, die Nullhypothese abzulehnen, wenn sie tatsächlich wahr ist, während ein Fehler vom Typ II bedeutet, dass die Nullhypothese nicht abgelehnt wird, wenn sie falsch ist.

Sie können das Risiko dieser Fehler minimieren, indem Sie ein optimales Signifikanzniveau auswählen und eine hohe Leistung sicherstellen. Es gibt jedoch einen Kompromiss zwischen den beiden Fehlern, daher ist ein ausgewogenes Verhältnis erforderlich.

Frequentist versus Bayesian statistics

Traditionell betont die Frequentist Statistics das Testen der Signifikanz von Nullhypothesen und beginnt immer mit der Annahme einer echten Nullhypothese.

Die Bayes’sche Statistik hat jedoch in den letzten Jahrzehnten als alternativer Ansatz an Popularität gewonnen. Bei diesem Ansatz verwenden Sie frühere Forschungsergebnisse, um Ihre Hypothesen basierend auf Ihren Erwartungen und Beobachtungen kontinuierlich zu aktualisieren.

Der Bayes-Faktor vergleicht die relative Evidenzstärke für die Nullhypothese mit der Alternativhypothese, anstatt eine Schlussfolgerung über die Ablehnung der Nullhypothese zu ziehen oder nicht.

Häufig gestellte Fragen zur statistischen Analyse

Die statistische Analyse ist die wichtigste Methode zur Analyse quantitativer Forschungsdaten. Es verwendet Wahrscheinlichkeiten und Modelle, um Vorhersagen über eine Population aus Stichprobendaten zu testen.

Deskriptive Statistiken fassen die Merkmale eines Datensatzes zusammen. Mit Inferenzstatistiken können Sie eine Hypothese testen oder beurteilen, ob Ihre Daten für die breitere Bevölkerung verallgemeinerbar sind.

Hypothesentests sind ein formales Verfahren zur Untersuchung unserer Vorstellungen von der Welt anhand von Statistiken. Es wird von Wissenschaftlern verwendet, um bestimmte Vorhersagen, sogenannte Hypothesen, zu testen, indem berechnet wird, wie wahrscheinlich es ist, dass ein Muster oder eine Beziehung zwischen Variablen zufällig entstanden sein könnte.

Beim Testen statistischer Hypothesen sagt die Nullhypothese eines Tests immer keinen Effekt oder keine Beziehung zwischen Variablen voraus, während die Alternativhypothese Ihre Forschungsvorhersage eines Effekts oder einer Beziehung angibt.

Die statistische Signifikanz ist ein Begriff, der von Forschern verwendet wird, um festzustellen, dass es unwahrscheinlich ist, dass ihre Beobachtungen unter der Nullhypothese eines statistischen Tests stattgefunden haben könnten. Die Signifikanz wird normalerweise durch einen p-Wert oder Wahrscheinlichkeitswert bezeichnet.

Die statistische Signifikanz ist willkürlich – sie hängt vom vom Forscher gewählten Schwellenwert oder Alpha-Wert ab. Der häufigste Schwellenwert ist p < 0,05, was bedeutet, dass die Daten unter der Nullhypothese wahrscheinlich weniger als 5% der Zeit auftreten.

Wenn der p-Wert unter den gewählten Alpha-Wert fällt, sagen wir, dass das Ergebnis des Tests statistisch signifikant ist.